Num palácio de colunas avermelhadas às margens do sagrado Ganges, reinava Sheram, soberano do florescente Império Gupta (período áureo da civilização indiana, cerca de 500 d.C.). Numa manhã, com os corredores exalando incenso, chegou à corte Sessa ben Dahir, um brâmane matemático que trazia um tabuleiro de madeira talhado com 64 casas alternadas de ébano e osso (8 x 8 casas).

Sessa ajoelhou-se diante do soberano e dispôs pequenas peças em forma de infantaria, cavalaria, elefantes e carros de guerra. O jogo emulava um campo de batalha, prometendo condensar toda a estratégia humana de guerrear sem derramar uma gota de sangue. Poucos lances demonstrativos foram suficientes para incendiar a imaginação do rajá, que enxergou ali não apenas um passatempo, mas um espelho fiel das campanhas que teciam seu império. Vendo o brilho nos olhos do monarca, o brâmane recusou joias, terras e títulos; pedindo apenas que um grão de trigo fosse apostado na primeira casa do tabuleiro e o dobro na seguinte, continuando assim até a última jogada. Quem vencesse o jogo levaria a soma inteira. O pedido soou tão modesto que arrancou risadas abafadas da corte. Sheram, generoso, aceitou jogar.

Na jogada 1, a aposta foi de 1 grão, cerca de 0,05 grama de trigo. Na segunda jogada, a casa do tabuleiro receberia 2 grãos e na jogada 3 já eram 4 grãos. Na casa 10, o tabuleiro já acumulava 512 grãos (25 gramas de trigo). Pela primeira vez, os sábios locais tiveram contato com a aritmética da “contagem exponencial”. Na jogada 20, o acúmulo era de 524.288 grãos, ou um saco de 26 kg de trigo. Na 30, já eram 536.870.912 grãos (26 toneladas); e na jogada 40, a aposta chegava a mais de 1,1 trilhão de grãos (quase 55 mil toneladas, peso que exigiria uma frota de navios oceânicos).

Ao alcançar a jogada 64, o cálculo exigia caravanas carregadas de ouro para comprar trigo além-fronteira. Sheram empalideceu: sua fortuna, seu exército e seu reino caberiam dentro daquele tabuleiro-algoritmo, que, sua mente treinada apenas com tributos lineares, jamais poderia prever. Não se sabe bem qual foi o desfecho dessa primeira apresentação do jogo de Xadrez a um monarca indiano. Mas a lenda espalhou-se dos riquíssimos grotões de Bengala aos desertos persas, ensinando, em sussurros, a lição que os séculos ecoariam: “o crescimento exponencial parece singelo quando inicia, mas, de repente, salta ao incomensurável e transforma qualquer prudência em ruína, ou glória”.

Saltamos quinze séculos: o tabuleiro de tamarindo virou uma lâmina de silício, as casas de ébano transformaram-se em fileiras de transistores e, no lugar de grãos de trigo, empilhamos elétrons codificados (zeros e uns). A mesma progressão binária que atordoou Sheram acontece agora em trilhões de vezes por segundo dentro de cada chip. Como antes, parece discreta até cruzar a metade do tabuleiro, quando de repente engole legiões de dados e milhares de centrais energéticas, desestabilizando a prudência econômica e sociológica.

Podemos dizer que em 2008, o avanço computacional chegou à 6ª fileira do tabuleiro, ou 4 bilhões de grãos. Ao entrar no ciclo das Inteligências Artificiais Generativas (2023), os sistemas computacionais já ultrapassavam 4 trilhões de grãos, ou seja, em 2024 um dólar comprava algo como 300 trilhões de “grãos” de computação (3 × 10¹⁴ operações-computacionais-elementares por segundo). No mesmo compasso exponencial, “em 2030, o mesmo dólar comprará perto de 18 quintilhões de operações, um salto superior a 60 mil vezes de poder computacional adquirido por cada dólar hoje”(fonte: estudo “Big Ideas 2025” da ARK Invest). Se você está como o rajá Sheram, perturbado com a ‘contabilidade agressiva do crescimento exponencial’, talvez desista deste texto, ele pode estragar seu dia.

Trazendo essa exponencialidade para a Saúde: em 2024, um único dólar já comprava algo em torno de 10¹⁸ operações matemáticas por segundo; um poder suficiente para analisar um “genoma humano completo em menos de um minuto” (em 2001 levava-se perto de 1,4 bilhão de minutos de CPU para interpretar um genoma). Mantido o ritmo de aceleração exponencial, estima-se que esse mesmo dólar deverá comprar mais de 10²¹ operações por segundo em 2030, um salto superior a 1.000 vezes em apenas sete anos.

Dados do relatório “The Future of Healthcare 2025”, publicado em outubro de 2025 pelo Silicon Valley Bank, mostram que datacenters dedicados a drug-discovery, como o da Recursion, por exemplo, já multiplicaram em cerca de 30 vezes o seu poder de AI Training entre 2023 e 2025. Por outro lado, também neste ano, ferramentas de ‘provider operations’ (grande parte delas baseadas em IA multimodal) já absorvem 44% de todo o capital de risco em healthtech, sinalizando a rápida migração dos recursos financeiros para o núcleo clínico dos sistemas de saúde.

O que faremos com essa imensa massa de poder computacional dentro do bioma da saúde? Como os players do setor podem exponenciar suas práticas médico-administrativas nesse colossal tabuleiro computacional?

Há muitas respostas a essas perguntas, mas algumas delas foram oferecidas no estudo “Artificial intelligence and machine learning in infectious disease diagnostics: a comprehensive review of applications, challenges, and future directions”, publicado em outubro de 2025 pela Science Direct. Sua introdução vai direto ao ponto: “Os registros de saúde são digitalizados, imagens médicas e exames laboratoriais de rotina são abundantes, os sensores são mais baratos e a computação confiável agora cabe em bolsos e clínicas. A Inteligência Artificial e o Aprendizado de Máquina (IA/ML) podem transformar os dados em respostas oportunas. A Visão Computacional lê radiografias de tórax, lâminas de microscópio, afere exames laboratoriais em sinais vitais, avalia o risco de sepse; sem falar que LLMs resumem notas clínicas e ajudam a identificar patógenos e padrões de resistência. Com as devidas proteções e cautelas, a IA pode facilitar o diagnóstico de doenças infecciosas de forma mais rápida, equitativa e verdadeiramente escalável”.

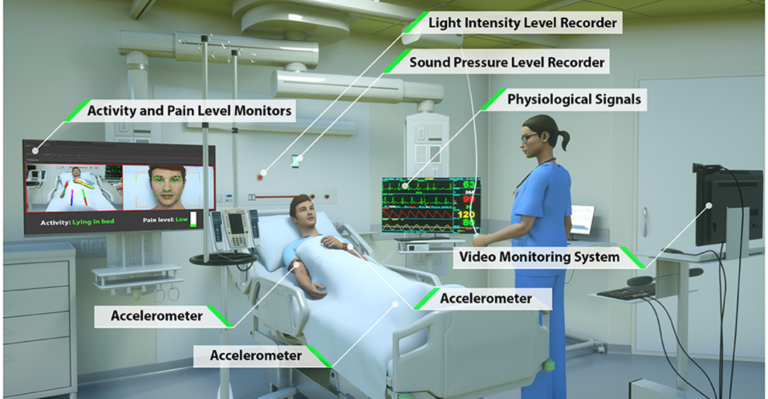

O estudo faz um mapeamento de algumas das aplicações da tecnologia de Visão Computacional (VC) para o ambiente hospitalar, destacando: (1) detecção precoce de delirium, dor e sedação por meio de microexpressões faciais e padrões de olhar; (2) vigilância automática de deterioração clínica (ex. frequência respiratória via movimento torácico, cianose de pele), acionando equipes de resposta rápida; (3) apoio à ventilação mecânica, da confirmação de posicionamento do tubo à previsão de assincronias paciente-ventilador; (4) rastreamento de mobilidade e saídas de leito, reduzindo risco de quedas; (5) salvaguardas de segurança, como identificação de objetos deixados no campo cirúrgico ou avaliação de higiene das mãos; (6) contagem de instrumentos e estimativa de perda sanguínea em tempo real durante cirurgias; (7) métricas de carga de trabalho usando câmeras para quantificar tarefas repetitivas da enfermagem; e (8) extensão do monitoramento visual no domicílio, capturando quedas ou adesão medicamentosa. Essas sugestões ilustram como a VC se transforma em câmera-sentinela de continuidade clínico-assistencial.

Nessa direção, a “Inteligência Artificial Multimodal”, que permite a visão computacional (VC), desponta como uma das tecnologias mais decisivas deste primeiro quarto de século, principalmente nas práticas médicas e na escala diagnóstica. Sob a alcunha de “Cognware”, ela abandona o papel passivo de uma câmera e converte-se em lente cognitiva que transubstancia fótons nos juízos clínicos. Ao enlaçar pixels com sinais térmicos, acústicos ou espectrais, ergue-se uma camada inteligente capaz de “colar” a sensorização na decisão clínica.

Vamos primeiro entender o contexto de “Visão Computacional”. Trata-se do campo das IAs que permite a sistemas computacionais enxergarem, identificarem, processarem, analisarem, compreenderem e explicarem o significado de qualquer conteúdo gerado por átomos (matéria física, tangível). Sensores digitalizam o conteúdo físico e o transformam em pixels, que por sua vez são transformados em ‘visão computacional’ por servidores de IA. O pixel (abreviatura de “picture element”) é, essencialmente, a “menor unidade de uma imagem ou de uma exibição digital”. É o componente fundamental e indivisível que compõe todo o elemento visual digital, assim como o “átomo é o bloco fundamental de toda a matéria física”.

O pixel é o menor ponto de amostragem capaz de ‘guardar um valor de luz’ (e cor), sendo registrado por sensores e exibido em telas. A resolução de uma imagem é simplesmente medida por quantos pixels estão presentes, tanto na largura quanto em altura. É a densidade total desses “átomos digitais” em uma tela que determina a fidelidade da imagem à realidade que nossos olhos veem. Mas acredite, nossos olhos não veem muito, e os olhos dos profissionais de saúde estão cansados e precisam de ajuda.

Teste de Cognware (Cognição Artificial Multimodal) que cada um pode fazer com VC: imagine usar seu smartphone, acrescido de uma plataforma de IA-Multimodal (a maioria dos LLMs já disponibiliza), para capturar a foto do prato de Strogonoff à sua frente. Os sensores da câmera registram a imagem e transformam a cena física (átomos, elementos tangíveis) em um conjunto de dados visuais, identificando “tudo” o que está no campo de visão da foto. Ainda é uma detecção bruta (a IA sabe que algo está lá, mas ainda não o descreve). Na sequência (fração de segundos), os sensores digitalizam a cena e a convertem em uma matriz de pixels, sendo esse o dado que entra na rede neural (“conversão de átomos em pixels/bits”). No próximo passo, a CNN (Rede Neural Convolucional), elemento interno da IA, processa o dado, limpa a imagem, corrige o brilho e começa a extrair características básicas: linhas, texturas e cores, já sendo capaz de detectar a borda redonda do prato, a cor marrom da carne e os demais elementos no prato.

As camadas mais profundas da rede neural usam as características processadas para identificar e isolar elementos específicos no prato, delimitando-os (exemplo: agrupa pixels como “Carne”, “Molho”, “Arroz”, “Batata Palha”, etc., caracterizando onde estão e o que são esses componentes). Imediatamente após, a CNN junta todas as análises e forma uma ‘conclusão de alto nível, com significado acionável’ (exemplo: “é um prato de strogonoff, com arroz branco e batata palha; a porção é de 400g e a estimativa calórica é de 750 kcal”). Nesse sentido, a CNN é a tecnologia que transforma a matriz de pixels brutos em uma representação que a IA possa “entender”, classificar e explicar. O resultado é quase um “pixel inteligente”, que não está na tela só para documentar, mas para desvendar, compreender e clarificar todos os detalhes ao usuário.

Se a “Visão Computacional” replica o que nossos olhos veem, o faz com muito mais precisão, sendo capaz de expor cada detalhe da imagem. Assim, cada quadrícula de luz digital é um ponto de medição que captura, com precisão micrométrica, as sutilezas que o olho humano tende a não perceber. Quando uma tomografia de 512 x 512, por exemplo, converte fótons em 262.144 valores de intensidade, ela entrega à IA um mosaico de evidências onde a calcificação coronariana, a infiltração tumoral e até o edema submilimétrico ganham coordenadas cartesianas.

O pacote Cognware (redes neurais convolucionais, transformers visuais e modelos de difusão), treinado com milhões de registros médicos (EHR, Estudos, Papers, Reports, Laudos, etc.), não só “enxerga” órgãos, mas manipula tensores de milhões de pixels que, combinados, codificam padrões histopatológicos invisíveis mesmo a um estetoscópio digital. Quanto mais fidedigno o pixel (sem ruído e sem compressão destrutiva), maior é a acurácia, reprodutibilidade e a chance de detectar uma pneumonia precoce ou um melanoma in situ. Assim, a “multimodalidade artificial das IAs” não só mostra o strogonoff, mas permite que você “converse” com ele. Médicos já conversam com imagens médicas diariamente por meio das plataformas de Computer Vision (já existem centenas no mercado).

No ambiente clínico-assistencial, que será fartamente ocupado pela “Computer Vision”, o pixel não é um mero ponto de cor: é a menor unidade de “verdade diagnóstica”, onde a medicina deixa de ser retina e se torna cálculo. No raio-X digital, cada pixel virou um laboratório, traduzindo a atenuação de fótons em unidades Hounsfield; na patologia digital, um corte histológico de ‘40 vezes’ pode comportar bilhões de pixels, permitindo que a IA encontre uma única célula tumoral na vastidão corada. Em essência, o “pixel passa a ser o átomo da informação visual”. Isolado, é só um número, em legião, tece a tapeçaria de diagnósticos, registros médicos e realidades aumentadas que estão redefinindo a nova medicina neste século.

Quando o pixel “ganha” um cérebro, começa a flertar com ondas de áudio, tabelas de laboratório, eletrocardiogramas, laudos, conversando com eles em linguagem natural. O que o médico terá daqui para frente é um banquete de dados clínicos depurados, onde cada modalidade traz “notícias diferentes do mesmo paciente” e a Multimodalidade costura tudo em tempo real para veredictos concisos. Assim, uma radiografia murmura “opacidade discreta”; o PCR sussurra “proteína inflamatória em alta”; o texto da enfermeira lembra “dispneia súbita” e a IA, sentada à cabeceira, converge as vozes num alerta de embolia que dispara antes de uma falha hemodinâmica. O pixel, agora inteligente e diplomado em outras realidades sensoriais, transforma o diagnóstico em um concerto sinfônico: quanto mais instrumentos entram na partitura, mais cedo o clínico escuta a melodia e decide a terapêutica que pode salvar uma vida.

Em outubro de 1903, o New York Times declarou corajosamente que os humanos levariam de 1 a 10 milhões de anos para inventar uma máquina voadora. Os irmãos Wright, apenas 69 dias depois, provaram que o editorial estava errado. Isso chama-se velocidade exponencial. Há poucas semanas, quase todos os jornais noticiaram o lançamento do Dekoda (criado pela Kohler Health), um dispositivo (“smart home camera”) para ser acoplado ao vaso sanitário, capaz de fotografar o “conteúdo circulante”. A partir das imagens, ele extrai métricas de forma, cor, consistência e outras características das fezes e urina. Os dados são processados por um modelo de IA/Machine Learning, que disponibiliza informações ao usuário por meio de um App. O device utiliza Computer Vision com sensores ópticos (“espectroscopia óptica”) e uma câmera embutida (clip-on) apontando para o interior do vaso (dispara LEDs quando detecta urina ou fezes). O algoritmo segmenta o bolo fecal, corrige brilho e cor, isolando as bordas. A CNN classifica o material (escala Bristol), avalia diâmetro, flutuabilidade, tonalidade, etc., comparando as aferições com milhões de padrões observados em bases clínicas. Devolve as informações ao usuário, por meio de alertas ou recomendações, em até 5 minutos. É cedo para saber se cumpre o que promete, mas é um exemplo de utilização em VC.

A indiana Remidio oferece o Remidio Fundus-on-Phone, que transforma um smartphone em um “oftalmoscópio cognitivo”: a câmera portátil captura o fundo de olho e o Medios DR (IA offline) analisa as imagens em segundos, informando se há retinopatia diabética referível (desempenho declarado de 93% em sensibilidade e 92,5% em especificidade). Sem depender da internet, o dispositivo é literalmente um “triager de bolso”. O MedEye, da Mint Solutions, por sua vez, é uma plataforma VC de verificação medicamentosa, que identifica comprimidos por meio de câmera e algoritmos, comparando cor, formato e gravação com a prescrição do prontuário, antes da ingestão.

Já a holandesa SkinVision transforma a selfie de uma “pinta em triagem on-demand de câncer de pele”. Por meio de Computer Vision, o usuário enquadra a lesão, e, em menos de meio minuto, a rede neural mede assimetria, borda, cor e diâmetro, devolvendo um score (baixo, moderado ou de alto risco). Em estudo publicado na JEADV (Journal of the European Academy of Dermatology and Venereology), o VC alcançou 95% de sensibilidade e 78% de especificidade, superando o exame visual de um clínico geral e alinhando-se às metas europeias de detecção precoce. A israelense Minuteful Kidney faz o mesmo pelo rim: após molhar uma fitinha em urina, o paciente posiciona-a sobre um cartão-padrão; a visão computacional do app calibra colorimetricamente a relação albumina/creatinina (em apresentação na ASN Kidney Week 2024, o teste caseiro exibiu 96,4% de sensibilidade e 84,2% de especificidade na detecção de albuminúria clínica, sendo o primeiro uACR doméstico aprovado pela FDA). Centenas de outras aplicações, devices, equipamentos e serviços com Computação Visual (IA Multimodal) já despontam diariamente nas cadeias de Saúde.

Apesar das evidências, em 23 de outubro de 2025, o The New York Times (NYT) publicou o texto “A próxima bolha econômica está aqui”, perguntando “se a economia da IA é uma bolha e se ela está para estourar”. É provável haver mais investimentos do que receitas no ecossistema da cognição artificial, e, talvez, esferoides de sabão evaporem aqui e ali. Todavia, sempre é interessante lembrar: no século XIX, a britânica “Railway Mania” autorizou a construção de 3.000 milhas de trilhos só em 1845 (investimentos de 7% do PIB), praticamente o que se havia construído nos 15 anos anteriores. Dois anos depois, a onda especulativa quebrou e dezenas de companhias faliram; mas, 6.220 milhas de ferrovias permaneceram e viraram a espinha dorsal do transporte global moderno. A história consagrou as ‘railways-manias’ como símbolos tardios da Primeira Revolução Industrial; enquanto os céticos preferem chamá-las de “cadeia especulativa abusiva”.

Outro déjà-vu ocorreu na ‘bolha ponto-com’, no final da década de 1990. Operadoras enterraram fibra ótica muito além da demanda e, quando a Nasdaq afundou, US$ 5 trilhões em valor de mercado evaporaram. A “sobra” de cabos e servidores, porém, virou a “rodovia” por onde trafega cada streaming que consumimos hoje. Dezenas de empresas se solidificaram e hoje dominam o mercado de conectividade (Google, Amazon, Microsoft, Oracle, etc.). O roteiro repete-se com a IA. Investidores destinaram US$ 252 bilhões a esse setor em 2024, enquanto a receita prevista de GenAI deve ficar em torno de US$ 70 bilhões em 2025, um fosso largo o bastante para engolir valuations inflados. Mas há controvérsias.

Jason Furman (entrevistado no artigo do NYT citado acima), professor em Harvard e ex-secretário no Governo Obama, publicou uma sequência de gráficos usando dados do Bureau of Economic Analysis (BEA), mostrandoque o agregado “information-processing equipment & software”, item da cesta que compõe o PIB norte-americano, respondeu por 92% do crescimento real da economia americana. Em outras palavras, o PIB do país no primeiro semestre de 2025 avançou cerca de 1,3% a.a.; mas sem os investimentos em estrutura e infraestrutura de IA, teria crescido míseros 0,1% a.a. Ainda assim, mesmo que haja uma bolha e ela estoure, o legado físico-cognitivo (modelos, infraestrutura, talentos, ciência, etc.) continuará rendendo dividendos civilizatórios pelas próximas décadas.

O raja Sheram pode ter perdido seu reino por não saber o que era contagem exponencial. Nós já sabemos. Estamos sentindo-a agora, com o chão tremendo sobre nossos pés e os setores produtivos tentando obter valor com essa constelação algorítmica-artificial. Bits, átomos e pixels correm agora na mesma estrada, no mesmo diapasão e com velocidade exponencial. Inovador é aquele homenzinho andarilho, suado e determinado que corre atrás das pessoas soprando fogo em seus ouvidos. Prepare-se, tempos quentes à frente.

Guilherme S. Hummel

Head Mentor – EMI (eHealth Mentor Institute)